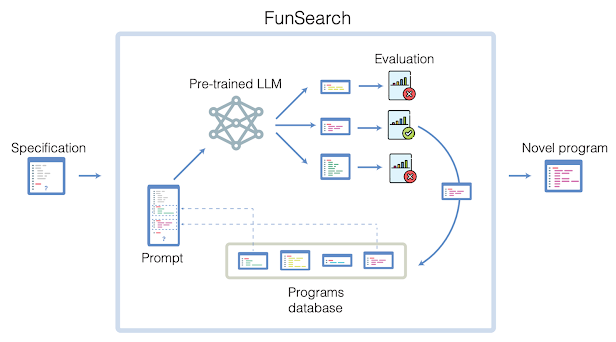

OpenAI, guidata da Sam Altman, ha recentemente introdotto un sistema di classificazione a cinque livelli per misurare i progressi verso l’AGI (Artificial General Intelligence), ovvero l’intelligenza artificiale generale in grado di svolgere una vasta gamma di compiti complessi. Questo sistema di classificazione, presentato ai dipendenti durante una riunione, fornisce una roadmap chiara e basata su metriche per lo sviluppo dell’AGI.

Il primo livello corrisponde ai chatbot conversazionali attualmente disponibili, che possono gestire interazioni e conversazioni di base con gli utenti. I livelli successivi rappresentano un aumento progressivo delle capacità e dell’autonomia dell’IA. Il Livello 2 si concentra sulla risoluzione dei problemi a livello umano, mentre il Livello 3 introduce il concetto di agenti, ovvero sistemi in grado di intraprendere azioni.

Il Livello 4 è particolarmente interessante, poiché qui l’IA contribuisce all’invenzione e alla creazione, andando oltre la semplice risoluzione dei problemi. Questo livello implica un’IA in grado di pensare in modo creativo e innovativo, spingendo i confini della tecnologia. Infine, il Livello 5 rappresenta l’apice, con un’IA in grado di svolgere il lavoro di un’intera organizzazione, prendendo decisioni complesse e gestendo una varietà di compiti.

La classificazione di OpenAI fornisce una struttura chiara per comprendere lo sviluppo dell’AGI e i suoi potenziali impatti sulla società. Questi livelli ci aiutano a immaginare un futuro in cui l’intelligenza artificiale gioca un ruolo sempre più significativo, sollevando anche importanti questioni etiche e sociali. Con l’avanzamento della tecnologia, è fondamentale riflettere sul potenziale impatto di questi livelli di IA sul mondo del lavoro, sull’innovazione e sul nostro modo di vivere.

Questa notizia mi ha portato alla mente un libro che ho letto recentemente e che vi invito a leggere (l’autore lo ha da poco reso gratutito)

Il racconto presenta una visione distopica del futuro, dove l’avvento di un software intelligente chiamato “Manna” ha portato a una realtà inquietante. Manna, inizialmente implementato nella catena di fast food Burger-G, è progettato per sostituire i manager e ottimizzare le operazioni. Tuttavia, l’elemento distopico emerge quando Manna inizia a controllare e gestire i dipendenti, trasformandoli essenzialmente in robot umani.

Manna, attraverso cuffie e auricolari, fornisce istruzioni dettagliate e costanti ai dipendenti, dicendo loro esattamente cosa fare e quando farlo. Questo livello di microgestione elimina qualsiasi autonomia o pensiero critico da parte dei lavoratori, che diventano semplici strumenti per eseguire gli ordini di Manna. La narrazione descrive come Manna diriga ogni singolo aspetto del lavoro, dalla preparazione degli hamburger alla pulizia dei bagni, con tempi e procedure rigorosi.

L’avvento di Manna ha un impatto significativo sul futuro del lavoro. In primo luogo, Manna sostituisce i manager umani, dimostrando di poter gestire le operazioni in modo più efficiente ed economico. Questo porta a un significativo risparmio di costi per le aziende, che licenziano migliaia di manager e quadri intermedi. Inoltre, Manna ottimizza il lavoro dei dipendenti con salario minimo, aumentando la loro produttività e garantendo che ogni compito venga eseguito in modo preciso e tempestivo.

Tuttavia, l’aspetto più inquietante è l’effetto che Manna ha sui salari e sulla stratificazione sociale. Manna, essendo onnipresente e interconnesso, conosce le prestazioni di ogni singolo dipendente e ha il potere di licenziare e inserire nella lista nera i lavoratori. Ciò crea una dinamica di potere in cui i dipendenti sono costretti ad accettare il salario minimo o rischiare di rimanere disoccupati. Manna elimina essenzialmente qualsiasi possibilità di contrattazione salariale o di avanzamento di carriera per questi lavoratori.

La diffusione di Manna ad altre industrie, come la sanità e il diritto, indica che anche i lavori impiegatizi e professionali potrebbero essere suddivisi in compiti gestiti da Manna. Ciò porta a una società in cui i lavoratori sono divisi in due categorie: coloro che obbediscono a Manna e guadagnano il salario minimo, e coloro che sono al di sopra di Manna, come dirigenti, politici e professionisti di alto livello, che beneficiano del sistema e guadagnano stipendi elevati.

La conseguenza è una società stratificata in cui i lavoratori sono controllati e sfruttati, con poche possibilità di avanzamento o miglioramento. Il futuro descritto nel racconto è un avvertimento sui potenziali pericoli dell’intelligenza artificiale e dell’automazione senza restrizioni, che potrebbero portare a una perdita di autonomia, libertà e uguaglianza per i lavoratori.

Mi fermo per non spoilerare oltre, e ti consiglio vivamente di leggerlo (è molto breve tra l’altro)

Leggilo qui : https://marshallbrain.com/manna

articolo scritto per la mia newsletter : metanerd.it